Vor ein paar Wochen noch als Gerücht durchs Netz gegeistert und nun doch Realität! Nvidia übernimmt die PhysX-Schmiede AGEIA Technologies, Inc.

Das 2002 gegründete, kalifornische Unternehmen brachte im Jahre 2006 die sogenannten PPU (Physics Processing Unit) mit Namen PhysX auf den Markt, die sich allerdings bis heute nur sehr mäßiger Beliebtheit erfreuten. Problem daran war, dass diese Technik nicht nur einen zusätzlichen PCI-Slot verschlang, aktiv gekühlt und mit einem zusätzlichen Stromanschluss versehen wurde, sondern auch an der flächendeckender Unterstützung der Spieleentwickler mangelte es und nur vereinzelte Titel werden bis heute unterstützt. Anfänglich noch mit Preisen um die 300 Euro-Marke gehandelt, werden fast zwei Jahre nach deren Einführung immer noch mindestens 112 Euro für eine PhysX-Karte von den einzigen beiden Firmen, nämlich BFG und Asus, die die Karten exklusiv vertreiben, fällig.

Mit der Übernahme seitens Nvidia wird sich wohl in Zukunft einiges bei AGEIA verändern. So will man die Rechenleistung der hauseigenen GeForce-Chips ebenfalls für Physik-Berechnungen heranziehen. Bislang kann AGEIAs PhysX-Engine neben den eigenen PhysX-Chips nur die Hauptprozessoren für etwaige Berechnungen nutzen. Der größte Konkurrent namens Havok Physics, der seit einiger Zeit zu Intel gehört, kann für seine Berechnungen ebenfalls nur CPUs, und zwar nur die aus eigenem Hause, nutzen, nachdem Havok FX, welche die Grafikkarten von Nvidia und ATi ebenfalls unterstützte, kurz nach der Übernahme seitens Intel scheinbar still und heimlich begraben wurde. Aufgrund dessen hatte Ageia ihr Software Development Kit (SDK) schon kostenlos angeboten, um sich Marktanteile zu sichern, was aber kaum fruchtete. Mit Nvidia könnte allerdings nun der Schritt zur Massenmarkttauglichkeit gegeben sein.

Nvidia-Chef Jen-Hsun Huang möchte die Entwickler von Nvidia und PhysX vereinigen, um "GeForce-beschleunigtes PhysX" in einer möglichst breiten Anwendungspalette anzubieten. Das Nachsehen hat wie so oft Konkurrent AMD/ATi, da die konkurrierenden Physik-Beschleunigungsschnittstellen zueinander inkompatibel sind. Nvidia setzt hierbei auf ihre GeForce-zentrierte GPU-Computing-Schnittstelle "CUDA", die dann wohl auch PhysX nutzen wird.

Informationen über die finanziellen Details sind leider bislang nicht bekannt gegeben worde. Ebenso fehlen Informationen darüber, wie Käufer der PhysX-Karten in Zukunft behandelt werden, da eine Konzentration auf die CPU und GPU die Zusatzkarten wohl komplett überflüssig machen könnte.

Kryptowährungen haben in den letzten Jahren erheblich an Popularität gewonnen, nicht nur als Anlageform, sondern auch als technologische Innovation, die...

Derzeit schränken viele Online-Händler das Widerrufsrecht für Verbraucher ein. So will ein großes amerikanisches Unternehmen Berichten zufolge die Rückgabefrist für...

Die KIOXIA Europe GmbH, ein weltweit führender Anbieter von Speicherlösungen, hat heute die Einführung der SD-Speicherkartenserie EXCERIA G2 bekannt gegeben....

Hobbyhandwerker sind begeistert von ihren Elektrowerkzeugen. Das Multimeter steht dabei im Schatten von Bohrmaschinen und Schleifgeräten und erhält wenig Beachtung....

Wie Speicherspezialist Western Digital mit der WD_BLACK SN770M NVMe SSD (Test), bietet auch Mitbewerber Seagate eine M.2 2230-Lösung für Handheld-Gaming-PCs...

Mit der FireCuda 520N bietet Seagate eine Upgrade-SSD für Gaming-Handhelds wie Valve Steam Decks, ASUS ROG Ally, Lenovo Legion Go, Microsoft Surface und andere an. Wir haben die kompakte M.2 2230 SSD getestet.

Mit der EXCERIA PLUS G3 bietet KIOXIA eine Consumer-SSD mit PCI Express 4.0 x4 Interface an. Wir haben uns das 2-TB-Modell der Serie, basierend auf BiCS5-Flashspeicher, im Test genau angesehen und verglichen.

KIOXIA bietet mit der EXCERIA PRO einen Serie interner PCIe Gen4 SSDs an, die für Kreative, Gamer und Profis konzipiert ist. Wir haben uns im Praxistest das 2-TB-Modell der Familie zur Brust genommen.

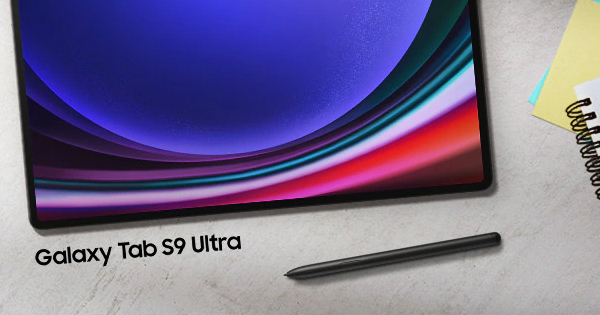

Vergangenen Sommer präsentierte Samsung die neue Galaxy Tab S9 Familie mit Dynamic AMOLED-Displays und der Qualcomm Snapdragon 8 Gen2 Plattform. Wir haben uns das S9 Ultra in einem Kurztest angesehen.